لوهلة، قد يبدو العنوان أدناه ضرباً من ضروب الخيال العلمي. ولكن تطور الآلات الذكية والبرامج الحاسوبية التي باتت «قادرة على التصرف»، وليست السيارات الذكية من دون سائق إلا بعضها، بات يحتم تحديد المسؤوليات في حال أساءت هذه الآلات التصرف. فظهرت طلائع البحث القانوني في ما لهذه الروبوتات من حقوق وما عليها من مسؤوليات، لمواجهة ما قد تتسبب به من قضايا خلافية حول أدائها ومسؤولياتها.

لوهلة، قد يبدو العنوان أدناه ضرباً من ضروب الخيال العلمي. ولكن تطور الآلات الذكية والبرامج الحاسوبية التي باتت «قادرة على التصرف»، وليست السيارات الذكية من دون سائق إلا بعضها، بات يحتم تحديد المسؤوليات في حال أساءت هذه الآلات التصرف. فظهرت طلائع البحث القانوني في ما لهذه الروبوتات من حقوق وما عليها من مسؤوليات، لمواجهة ما قد تتسبب به من قضايا خلافية حول أدائها ومسؤولياتها.

في أواخر يونيو 2016م، أشار عدد من المواقع الإخبارية الكبرى إلى مسودة قانونية صادرة عن لجنة الشؤون القانونية بالاتحاد الأوروبي، تتضمن اقتراحاً بأن تكون للإنسان الآلي (الروبوت) حقوق كحقوق العمّال! وتؤكد هذه المسودة مراراً على أن الروبوتات هي «شخوص

«تاي» هو برنامج ذكاء صناعي يقوم بالكتابة والرد على المغرِّدين. وفي خلال ساعات قليلة من تفاعله مع المستخدمين والتعلم منهم، أصبح عنصرياً وقحاً وسارعت «مايكروسوفت» إلى حذف التغريدات، وإيقاف نشاط الحساب

إلكترونية» يجب أن تكون لديها الأهلية القانونية للمتاجرة بالأموال، واستحقاق التعويضات حين يلحق بها أي نوع من الضرر. وعلى الجانب الآخر من الأطلسي، وفي 2014م، أعلن مكتب البحوث البحرية التابع لإدارة البحرية الأمريكية عن منحة بقدر 7.5 مليون دولار ستصرف على مدى خمسة أعوام للباحثين من مختلف الجامعات الأمريكية من أجل بحث بناء الحس الأخلاقي والتفكير في مآلات الآلات والروبوتات الذكية. هكذا نجد أن الحديث عن «الأخلاقية الروبوتية» لم يعد من نسج أفلام الخيال والروايات بل تحوَّل إلى مشروع حقيقي تحت مظلة المشرّع الحكومي.

الروبوت الذي نتحدَّث عنه ليس بالضرورة «رجلاً آلياً» يمشي على رجلين ويتحدث إليك بصوت معدني. فمظاهر الذكاء الصناعي باتت من حولنا دون أن تكون مرئية بالضرورة، إنها في الذراع الروبوتي الذي يركِّب سيارتك في المصنع، وفي التطبيق الذكي الذي يتابع ترتيبات سفرك بهاتفك الجوال. وإذا ضمنّا كل التطبيقات الطبية والعسكرية والتعليمية المبنية على تقنيات الحوسبة السحابية و«البيانات الكبرى» التي تعززها، فسنجد أننا مغمورون بالذكاء الآلي في كثير من تفاصيل حياتنا.

الروبوت الذي نتحدَّث عنه ليس بالضرورة «رجلاً آلياً» يمشي على رجلين ويتحدث إليك بصوت معدني. فمظاهر الذكاء الصناعي باتت من حولنا دون أن تكون مرئية بالضرورة، إنها في الذراع الروبوتي الذي يركِّب سيارتك في المصنع، وفي التطبيق الذكي الذي يتابع ترتيبات سفرك بهاتفك الجوال. وإذا ضمنّا كل التطبيقات الطبية والعسكرية والتعليمية المبنية على تقنيات الحوسبة السحابية و«البيانات الكبرى» التي تعززها، فسنجد أننا مغمورون بالذكاء الآلي في كثير من تفاصيل حياتنا.

ما هي تبعات هذا الذكاء؟ قانونياً وأخلاقياً؟

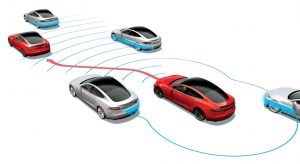

مثل هذه الأسئلة الكبرى تواجهها اليوم الشركات والجهات الكبرى التي تصنّع هذه التقنيات الروبوتية. إذ يستثمر الجيش الأمريكي المليارات من الدولارات في الآلات المتقدمة والروبوتات الحربية التي قد تغيِّر مسار الحرب تماماً في المستقبل. وعلى الرغم من أن قوانين الجيش الأمريكي الآن تمنع استخدام الروبوتات المستقلة القاتلة، أو الروبوتات شبه المستقلة القادرة على القتال إلا بتحكم بشري مسبق، إلا أن تسارع البحوث في علوم الروبوتات يجعل من رفع هذا المنع مسألة وقت فحسب، ليصبح الروبوت المستقل قادراً على اتخاذ القرارات بنفسه. أما في عالم الأعمال، فليس خفياً الجهد المضني الذي تبذله كبريات الشركات التقنية مثل «تِسلا» و«غوغل» و«أوبر» لبناء سيارات ذاتية القيادة، تلك التي تسيّر نفسها بنفسها دون الحاجة إلى سائق بشري. وبناء مثل هذه السيارات لا بد وأن يتضمن التحسب لمواقف تكون فيها السيارة المستقلة أمام خيارات صعبة مثل الاختيار بين التسبب في وفاة عدد من المشاة أو الانحراف عن الطريق لإلحاق الضرر بالسيارة وبراكبها. أضف إلى هذه الشواهد الواقعية تقديرات بأن تكون السيارات الآلية المستقلة ذاتية القيادة في الأسواق خلال السنوات العشر المقبلة، فيما تقدّر بعض شركات بناء الروبوتات في ألمانيا أن تكون الروبوتات الآلية المستقلة القادرة على العمل في الأسواق بحلول 2050م.

مثل هذه الأسئلة الكبرى تواجهها اليوم الشركات والجهات الكبرى التي تصنّع هذه التقنيات الروبوتية. إذ يستثمر الجيش الأمريكي المليارات من الدولارات في الآلات المتقدمة والروبوتات الحربية التي قد تغيِّر مسار الحرب تماماً في المستقبل. وعلى الرغم من أن قوانين الجيش الأمريكي الآن تمنع استخدام الروبوتات المستقلة القاتلة، أو الروبوتات شبه المستقلة القادرة على القتال إلا بتحكم بشري مسبق، إلا أن تسارع البحوث في علوم الروبوتات يجعل من رفع هذا المنع مسألة وقت فحسب، ليصبح الروبوت المستقل قادراً على اتخاذ القرارات بنفسه. أما في عالم الأعمال، فليس خفياً الجهد المضني الذي تبذله كبريات الشركات التقنية مثل «تِسلا» و«غوغل» و«أوبر» لبناء سيارات ذاتية القيادة، تلك التي تسيّر نفسها بنفسها دون الحاجة إلى سائق بشري. وبناء مثل هذه السيارات لا بد وأن يتضمن التحسب لمواقف تكون فيها السيارة المستقلة أمام خيارات صعبة مثل الاختيار بين التسبب في وفاة عدد من المشاة أو الانحراف عن الطريق لإلحاق الضرر بالسيارة وبراكبها. أضف إلى هذه الشواهد الواقعية تقديرات بأن تكون السيارات الآلية المستقلة ذاتية القيادة في الأسواق خلال السنوات العشر المقبلة، فيما تقدّر بعض شركات بناء الروبوتات في ألمانيا أن تكون الروبوتات الآلية المستقلة القادرة على العمل في الأسواق بحلول 2050م.

ضبط السلوك الأخلاقي للروبوت

ضبط السلوك الأخلاقي للروبوت

تشعب الحديث عن أخلاقيات الآلة وأخلاقيات الروبوتات جعل من هذا المجال موضوعاً للبحث العلمي والفلسفي. فهناك مستوى يبحث في أخلاقيات بناء وتصميم الآلات الذكية. أما المجال الأهم والأكثر إثارة فيبحث في كيفية بناء آلات ذكية تتمتع بقدر من الأخلاق أو القيم الأخلاقية، وبالتالي قادرة على التصرف على أساس أخلاقي. هذا السؤال يشكِّل تحدياً كبيراً في عالم أبحاث الروبوتات والذكاء الصناعي وعلى مستويين: مستوى المبدأ ومستوى التطبيق. فكيف يمكن للآلة على مستوى التطبيق أن تتعلم الأخلاق كمبادئ؟ قد يكون الجواب السهل أن عليها أن تتعلم من البيئة والتفاعل مع المحيط. لكن هذا قد يقود إلى نتائج كارثية. فعلى سبيل المثال، أجريت دراسة في معهد البحوث المتقدمة في سويسرا عام 2009م حيث بُرمجت مجموعة من الروبوتات على التعاون في مهمة البحث عن مصادر غذائية معينة، لكن ما حصل مع مرور الوقت هو أن الروبوتات بدأت تتعلَّم الكذب والتدليس حتى تزيد من انتفاعها بالمصادر بمفردها. في مارس 2016م، أطلقت «مايكروسوفت» حساب «Tay» في تويتر، وهو عبارة عن برنامج ذكاء صناعي يقوم بالكتابة والرد على المغرِّدين. وفي خلال ساعات قليلة من تفاعل تاي مع المستخدمين والتعلم منهم، أصبح عنصرياً وقحاً، وسارعت «مايكروسوفت» إلى حذف التغريدات، وإيقاف نشاط الحساب الذي لم يعش إلا يوماً واحداً فقط!

أما وسائل التطبيق الأخرى، فتتضمن غرس هذه المبادئ برمجياً في الشفرة المصدرية للروبوت الآلي. ولكن هذا سيجرنا إلى مستوى المبدأ، وهو أي أخلاق يجب أن نعلّمها للآلة؟ وعلى الرغم من أن برمجة الأخلاق تعتمد بشكل أساسي على تحليل عواقب الأفعال وتقييمها، إلا أن السؤال الملح يبقى، من يحدد المعايير الأخلاقية التي تتمتع بها الآلة؟

أما وسائل التطبيق الأخرى، فتتضمن غرس هذه المبادئ برمجياً في الشفرة المصدرية للروبوت الآلي. ولكن هذا سيجرنا إلى مستوى المبدأ، وهو أي أخلاق يجب أن نعلّمها للآلة؟ وعلى الرغم من أن برمجة الأخلاق تعتمد بشكل أساسي على تحليل عواقب الأفعال وتقييمها، إلا أن السؤال الملح يبقى، من يحدد المعايير الأخلاقية التي تتمتع بها الآلة؟

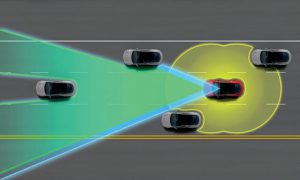

ارتطمت سيارة تسلا – التي كانت تقود نفسها ذاتياً – بشاحنة معترضة، مما نتج عن هذا الحادث الشنيع وفاة قائد المركبة، حيث أسفرت تحقيقات الحادث عن عدم تمييز حساسات السيارة لهيكل الشاحنة المقبلة. السؤال الآن: مَنْ يتحمَّل نتيجة الحادث؟

«حقوق الآلات» أو «حقوق الروبوتات» قد يكون مصطلحاً مبكراً، وما زال أمامنا كثير لنصل إليه. لكن الحديث في الأروقة القانونية عن عمل الآلات ذاتية القيادة هو من صلب الحاضر. فالسيارة ذاتية القيادة تواجه سيلاً هائلاً من البيانات عبر الحساسات المختلفة، لتزودها بمختلف المعلومات. ومن خلال هذه المعلومات تحاول خوارزميات الذكاء الصناعي أن تبني السيناريو الأمثل وتتخذ القرار الأصوب.

مسؤولية السيارات دون سائق مثلاً!

لكن هناك مستويات كثيرة للقرار الحاسوبي. فقد تكون المعطيات مشوشة وغامضة تؤدي إلى نتائج كارثية لا تخلو من تبعات أخلاقية. ففي شهر يونيو الماضي ارتطمت سيارة تسلا – التي كانت تقود نفسها ذاتياً – بشاحنة معترضة، مما نتج عن هذا الحادث الشنيع وفاة قائد المركبة، حيث أسفرت تحقيقات الحادث عن عدم تمييز حساسات السيارة لهيكل الشاحنة المقبلة. السؤال الآن: مَنْ يتحمَّل نتيجة الحادث؟ هل يتحمله المبرمج الذي صمم طريقة عمل الحساسات، أم مبرمج السيارة أم السائق نفسه الذي لا حول له ولا قوة؟ أما الجانب الآخر من القرار فهو الجانب النفعي الذي يحدِّد البوصلة الأخلاقية للقرار، فحين تسير السيارة بسرعة كبيرة وتكون أمام خيارين: إما أن تقتل المشاة في وسط الشارع أو ترتطم بأي حاجز يحطمها ويقتل راكبيها، فعلى أي أساس يتم تفضيل القرار الأول من القرار الثاني؟ هل يكون الأمر على أساس تقليل الخسائر أم حماية الآلة لنفسها من الهلاك؟

لكن هناك مستويات كثيرة للقرار الحاسوبي. فقد تكون المعطيات مشوشة وغامضة تؤدي إلى نتائج كارثية لا تخلو من تبعات أخلاقية. ففي شهر يونيو الماضي ارتطمت سيارة تسلا – التي كانت تقود نفسها ذاتياً – بشاحنة معترضة، مما نتج عن هذا الحادث الشنيع وفاة قائد المركبة، حيث أسفرت تحقيقات الحادث عن عدم تمييز حساسات السيارة لهيكل الشاحنة المقبلة. السؤال الآن: مَنْ يتحمَّل نتيجة الحادث؟ هل يتحمله المبرمج الذي صمم طريقة عمل الحساسات، أم مبرمج السيارة أم السائق نفسه الذي لا حول له ولا قوة؟ أما الجانب الآخر من القرار فهو الجانب النفعي الذي يحدِّد البوصلة الأخلاقية للقرار، فحين تسير السيارة بسرعة كبيرة وتكون أمام خيارين: إما أن تقتل المشاة في وسط الشارع أو ترتطم بأي حاجز يحطمها ويقتل راكبيها، فعلى أي أساس يتم تفضيل القرار الأول من القرار الثاني؟ هل يكون الأمر على أساس تقليل الخسائر أم حماية الآلة لنفسها من الهلاك؟

المجال الأهم والأكثر إثارة يبحث في كيفية بناء آلات ذكية تتمتع بقدر من الأخلاق أو القيم الأخلاقية…

للإجابة عن هذا السؤال، حدَّد روائي الخيال العلمي إسحق عظيموف – في الخمسينيات الميلادية – ثلاث قواعد أخلاقية للروبوتات. والمدهش أننا بعد نحو سبعة عقود ما زلنا نعتمد على هذه القواعد التي تنص على التالي:

• القاعدة الأولى: ألا يتسبب الروبوت بالضرر لأي إنسان وألا يسمح بحصول الضرر لأي إنسان.

• القاعدة الثانية: أن يتبع الروبوت أوامر الإنسان إلا إن تعارضت مع القاعدة الأولى.

• القاعدة الثالثة: أن يحمي الروبوت نفسه طالما أن هذا لا يتعارض مع القاعدتين الأولى والثانية.

لكن قواعد عظيموف تعرَّضت للنقد مؤخراً، ليس لأنها غير واقعية أو مستعصية على التنفيذ، بل لأنها مبهمة. فكيف نعلِّم الروبوتات معنى «الضرر» وحدوده وبالتالي تقديره بشكل صحيح؟ وماذا عن الاستثناءات غير المحدودة التي، كبشر، نراها من البديهيات كما يفعل الأطباء مع المرضى على سبيل المثال. كيف نستطيع حقن الروبوت بكل هذه المعارف؟

لكن قواعد عظيموف تعرَّضت للنقد مؤخراً، ليس لأنها غير واقعية أو مستعصية على التنفيذ، بل لأنها مبهمة. فكيف نعلِّم الروبوتات معنى «الضرر» وحدوده وبالتالي تقديره بشكل صحيح؟ وماذا عن الاستثناءات غير المحدودة التي، كبشر، نراها من البديهيات كما يفعل الأطباء مع المرضى على سبيل المثال. كيف نستطيع حقن الروبوت بكل هذه المعارف؟

السؤال الأهم الذي ينتظر مستقبل فلاسفة الحاسب والذكاء الصناعي يدور حول أهمية المشاعر الإنسانية في توجيه بوصلتنا الأخلاقية. التعاطف والألم والحب والسعادة ليست عمليات حسابية تجري داخل أدمغتنا، بل تجارب واعية تتحكم بتوجهاتنا الأخلاقية.

فهل سيهتدي العلماء والباحثون إلى تحويل كل هذه الأحاسيس إلى عمليات حسابية بلغة الصفر والواحد، حتى يكون لأخلاق الروبوتات بُعد عاطفي؟ أم أننا – نحن البشر – لدينا من الغرور ما يعمينا عن احتمال ألا يكون لهذه العواطف علاقة بقراراتنا الأخلاقية؟ لعلنا سننتظر وندع الروبوت يجيب بنفسه.