ما زالت الجدليات الأخلاقية حول النعجة دولّي حاضرة في ذاكرة العلم البشري، بعد أن ملأت الدنيا وشغلت الناس، قُبيل بداية الألفية الثالثة. ويبدو أن مطلع العقد الثالث من الألفية نفسها يشهد جدليةً كُبرى جديدة، ولكن في اتجاه تقني لا حيوي بعد التداعيات القانونية والأخلاقية التي حركتها تقنية “شات جي بي تي” وما أشبهها من تقنيات الذكاء الاصطناعي.

“القافلة” تستكشف أبعاد القضية في هذه الصفحات من جوانبها التقنية والمعرفية والأخلاقية والقانونية، حيث تتناول ذلك ضمن ثلاثة أبعاد رئيسة:

الأول: يتأمل فريق التحرير ويقارن طريقة عمل “شات جي بي تي”، في جمع المعلومات آليًّا، وتنظيمها آليًّا كذلك، وهي عملية تشبه آلية المكنسة الكهربائية وإفراغها. ومن مخاطر هذه العملية أنها تجعل الصدارة للأشهر بدلًا من الأصح في قضية ما.

الثاني: يقدِّم أستاذ اللسانيات الحاسوبية والإعلام الرقمي في الجامعة اللبنانية

د. غسّان مراد، أشكال المخاطر التي جاء بها جيل جمع المعلومات التوليدي، وبينها مخاطر اقتصادية ومعرفية وأخلاقية. وينبه مراد على ضرورة اتخاذ الحذر والبحث عن وسائل لتصفية البيانات للتقليل من احتمالات التزييف الإعلامي ونشر العنصرية، بالإضافة إلى مخاطر استخدام التقنية في جمع المعلومات التي تترتب عليها آثار عملية في حياة الناس مثل تحديد المستحقين للإعانات الحكومية.

الثالث: يتناول المتخصص في قوانين الملكية الفكرية الأستاذ راشد رداد الزهراني مع فريق التحرير، الاعتراضات القانونية على بعض أوجه نشاط الذكاء الاصطناعي، ومن بينها استنساخ الأعمال الفنية، بما في ذلك من إهدار لحقوق ملكية أصحابه، ومخاطر ذلك على مستقبل الإبداع البشري. كذلك يتناول المخاطر على مستقبل التعليم الجامعي في ظل إمكانية إعداد البحوث آليًّا، وأخيرًا وليس آخرًا، معضلة تسجيل براءات الاختراع التي تنتجها الآلة، إذ تحدِّد القوانين هذا الحق في الأشخاص الطبيعيين.

1 – أفلاطون الآلي يجيب ولا يسأل

في محاوراته الفلسفية التي قاربت الثلاثين، خـلَّد أفلاطون أستاذه سقراط وطريقته في نقل المعرفة إلى تلاميذه، حين جعله الشخصية الرئيسة في تلك المحاورات التي يطرح فيها سقراط الأسئلة على تلاميذه أكثر مما يقدِّم لهم من إجابات. والهدف هو دفعهم إلى البحث عن الأجوبة بأنفسهم، فإذا ما أجابوا عاد إليهم بطرح أسئلة جديدة حول الموضوع نفسه، بغية اختبار أصالة طرح التلميذ وقدرته على الصمود في وجه الطعن الفكري.

وبالمثل كان حكماء الشرق الصينيون واليابانيون والهنود يعتمدون على الوسيلة نفسها، ولم يزل شكل المحاورة ملهمًا لعديد من الكُتَّاب حتى اليوم.

في الصيحة العالمية التي بتنا نعرفها بـ “شات جي بي تي” وأمثاله من تطبيقات محاورات الذكاء الاصطناعي، تبرز المحاورة الأفلاطونية من حيث الشكل، لكنها في المنهج والمحتوى سارت على عكس منهج المُعلم سقراط بطل المحاورات الأفلاطونية.

إنها لا تطرح أسئلة بل تقدِّم إجابات، كانت تتسم بشيء من عدم الوضوح في بعض الأحيان لحظة الإعلان عن إطلاق برنامج “شات جي بي تي”، وهو أحد برامج الدردشة الآلية المدعومة بالذكاء الاصطناعي AI، في نوفمبر من العام الماضي. وكأن تلك الإجابات “الروبوتية” جاءت لتُعفينا نحن التلاميذ، من عناء التفكير والبحث، رغم ما ينطوي على تبعاتها من مخاطر.

كانت هناك قلَّة تنصح بالتفكير المتأني حول المخاطر المعرفية والأخلاقية والقانونية، ثم وجدت الدعوة صداها.

أرفند كريشنا

لقد كانت الدهشة عنوان تلك اللحظة، التي تسرَّع كثيرون في إبداء حماستهم ترحيبًا بالوافد الشبكي الجديد بوصفه وسيلة لخدمة البشرية ورفاهيتها، بينما اتجه آخرون إلى التحفظ باعتبارها تهديدًا لعديد من المهن التي يمكن أن تحل محلها.

بطبيعة الحال بدأت بعض الشركات في التفكير الجدي في مستقبل الوظائف التي لا تتعامل مع الجمهور، إذ صرح المدير العام لشركة “آي بي إم”، أرفند كريشنا، في مقابلته مع شبكة “بلومبيرغ”، أول مايو الماضي، بأن شركته تفكر في الاستغناء عن %30 من موظفي الموارد البشرية خلال السنوات الخمس المقبلة.

وفي مقابلة لاحقة مع شبكة “سي إن بي سي”، أكد كريشنا أن الذكاء الاصطناعي لن ينافس البشر، بل سيعيد توجيه العمالة البشرية، وضرب مثالًا بميكنة الزراعة التي تسببت في الاستغناء عن معظم العمالة اليدوية الزراعية، لكنها أعادت توجيه هذه المجهودات البشرية إلى وظائف مستحدثة.

التوليدية وكيس المكنسة

ولكي ندرك مدى خطورة البرنامج، لابد أن نتأمل طريقة عمل جيل محركات البحث السابق له والمستخدم حتى الآن، مثل محرك غوغل ومواقع التواصل الاجتماعي التي يشار إليها بـ “النماذج غير التوليدية”، والتي توفر المعلومات حول موضوع البحث من خلال روابط منفصلة، إذ يمكن للباحث أن يتصفحها رابطًا بعد آخر، وكل مادة، سواء أكانت مقالًا أم مقطع فيديو أم غير ذلك، لها وجودها الخاص وبتوقيع صاحبها، وقد تكون مرتبطة بمعلومات تعريفية عن صاحب الصفحة وضعها بنفسه عن نفسه، الأمر الذي يجعل المتصفح مدركًا للطبيعة الشخصية ولما يتلقاه من معلومات. وكلما فتح المتصفح رابطًا جديدًا حمل رأيًا مختلفًا، وتتسع رؤيته ويستطيع في النهاية أن يكوِّن رأيه من خلال اختلافات الآراء التي تلقاها.

وهذه المحركات، المنعوتة بغير التوليدية، ليست خالية من العيوب بطبيعة الحال، فهي ترتب روابط المقالات وفق برمجيات خاصة بها تأخذ في حسبانها أعداد الزائرين، أي طبقًا لشعبيتها.

ومعروف، بالطبع، أن الأكثر شعبية قد يكون الأقل قيمة، وهكذا يمكن للمتصفح أن يكتفي بالموضوعات الأقل قيمة التي تتصدر قائمة النتائج، بالإضافة إلى ما تقرره هذه الوسائل بنفسها من قيود قد لا تكون محقة فيها.

أما برامج الذكاء الجديدة التي تُعرف بالـ”توليدية” فهي مصممة لكي تمتص المعلومات آليًّا دون تدخل العقل البشري، وبالتالي تختزن كمية ضخمة من المعلومات تشبه حساءً موحدًا، وبالطبع لا بد أن يطغى فيه الرائج.

ويمكننا أن نُشبِّه هذه الآلية لجمع المعلومات بعمل المكنسة الكهربائية فوق سجادة، فهي تمتص الغبار والعملة المعدنية وربما خاتمًا ذهبيًا أو قرطًا، وربما حتى مفتاح البيت. ولأن التراب هو الغالب، فنحن لا نرى سواه عندما نُفرغ كيس المكنسة، ولن تظهر أشياؤنا المفقودة، ولن نجدها إلا إذا انتبهنا مسبقًا إلى أننا فقدنا شيئًا أثناء عملية الكنس، أو فيما لو عزمنا على غربلة كل هذا التراب ونكشه بحثًا عن الشيء المفقود.

إنه لمن سوء الطالع، إذا ما وجدنا أن كميات التراب أكبر من كميات الذهب على الشبكات وقواعد البيانات التي تصل إليها البرامج التوليدية، وهذا هو العيب البنيوي الأول لهذه الآلية.

باختصار، هناك تخوّف له أسبابه الوجيهة من أن يعمل أفلاطون الآلي على تحويل البشر كلهم إلى أطفال من السهولة بمكان يُتلاعَب بهم. هذه المخاطر تضع العلم في مواجهة الأخلاق، وكأننا بصدد امتحان جديد للبشرية ولكن موضوعه هذه المرَّة هو الذكاء الاصطناعي، الأمر الذي يذكرنا بأخطر الامتحانات التي تعرَّضت لها البشرية على أعتاب الألفية الثالثة بسبب الاستنساخ، عندما ولدت النعجة دولي عام 1996م استنساخًا من خلية ومن جنس واحد ومن نعجة دون تزاوج.

لم يتوقف الجدل الأخلاقي حول الاستنساخ حتى اليوم، وفيما يبدو أن الجدل حول أخلاقية الـ”شات جي بي تي” وأمثاله لن يتوقف قريبًا.

2 – إرهاصات القرصنة والعنصرية والتزييف العميق

د. غسان مراد

على الرغم من الفوائد التي تقدّمها برمجيات الذكاء الاصطناعي، فإن الدعوات أخذت تتصاعد من دول ومديرين وصنَّاع تقنيات محذرة من المخاطر المختلفة. تلك المخاطر مرتبطة بصراعات اقتصادية وسياسية، وبعضها متعلق بسرية الابتكارات، وبعضها لا ينفك تأثيره وتأثره بالأمن السيبراني وتصنيع الأسلحة.

هناك تحذيرات جادة وعميقة من إستراتيجيات خوارزمية في “النمذجة” الرقمية، تؤثر في ثقافة المجتمعات، خاصةً فيما يتعلق بحقوق الإنسان والحرية والتمييز.

مخاطر وحلول

أدّت هذه الإستراتيجيات، خاصة التي تعتمد على توليد النصوص من خلال البيانات المتاحة على الإنترنت، إلى توخي عديد من الدول والشركات الحذر في تعاملاتهم مع الشبكة أو المحيط الخارجي، ما أدّى إلى عدم استخدامها في مؤسسات عديدة وإيقافها في بعض الدول.

على سبيل المثال، فقد تمت الموافقة على نموذج “شات جي بي تي” واستخدامه في إيطاليا، بعد حظره في نهاية شهر مارس 2023م من هيئة حماية البيانات الشخصية الإيطالية.

وفي 13 أبريل 2023م، أعلنت إسبانيا فتح تحقيق حول “شات جي بي تي”، وهو اليوم الذي أطلق فيه الاتحاد الأوروبي مجموعة عمل لتعزيز التعاون الأوروبي حول معايير تنظيم الذكاء الاصطناعي.

وصادق نواب البرلمان الأوروبي في 14 يونيو على اقتراح قانون يضع قواعد للحدّ من المخاطر المرتبطة بالذكاء الاصطناعي، وهو اقتراحٌ سبق أن طُرح عام 2021م.

وبنظرةٍ سريعة، يصنّف القانون أنظمة الذكاء الاصطناعي وفقًا لأربعة مستويات من المخاطر، من “الأقل خطورة” إلى “غير المقبول”. هذه اللوائح المعتمدة ستُطبّق في أوروبا بعد الموافقة عليها من قِبل كلّ دول الاتحاد الأوروبي.

النماذج اللغوية وتنفيذ المهام

باتت النماذج اللغوية التي ترتكز إلى المعالجة الآلية للغات كـ “شات جي بي تي” أكثر انتشارًا. وآتت النتائج المولَّدة باهرة وهي تطبّق على لغات عديدة. ترتبط جودة النتائج ارتباطًا وثيقًا بعدد البيانات المتوفرة التي جرى تدريب خوارزمياتها عليها، إلى أن أصبح هذا النوع من الخوارزميات سائدًا في عددٍ كبير من البرمجيات المعتمدة على التعلّم الآلي من البيانات بأنواعها كافة.

بالنسبة إلى النماذج المعتمدة على خوارزميات الذكاء الاصطناعي، فمنها ما يعتمد على بيانات المستخدم كـ “فيسبوك” وغيره من برمجيات شبكات التواصل، ومنها ما هو توليدي، (GPT Generative Pretrained Transformer)، وهي المحولات التوليدية سابقة التدريب التي لا يُعرف بالتحديد كيف تُجري عملية التحولات اللغوية لبناء نص جديد من مجمل ما لديها من معلومات، إلا أنها تتعلّق بالسياق اللغوي لطلب المستخدم.

بشكل عام، تعمل هذه البرمجيات من خلال توقّع الكلمة أو العبارة التالية في محادثة ما بناءً على السياق والمعلومات المتاحة، وتستخدم شبكة عصبية تسمّى “المحوّل” لمعالجة المدخلات وتوليد استجابة. ما يقوم به البرنامج هو تشكيل علاقة بين الكلمات والجُمَل، بالاعتماد على حساب الاحتمالات. فعند التعرّف على كلمة مفتاحية معينة، يقوم البرنامج بالبحث عن سياق مفرداتها، ثم يقوم بالبحث عن سياق المفردتين للبحث عن المفردة الثالثة لإضافتها من خلال ما هو ممكن ومُدرج سياقًا في البيانات التي تدرّب عليها وهكذا، إلى أن يصل إلى حدٍّ ما، ثم يطلب من المستخدم المتابعة أو التوقف. هذا التفاعل، على الرغم من بساطته، يصبح أداةً لتعلّم البرنامج، فكلّ مستخدم هو أيضًا مساعد في تطويره.

تطرح هذه الآلية، نظرًا لارتباطها باللغة، أسئلة عديدة حول النتائج المولدة. كيف تختار هذه النماذج الجُمَل وعلى أي أساس تفضيلي؟ وهل تتعلّق بثقافة ما أو برأي معيَّن؟ فمن الممكن لهذه البرامج أن تعطينا مطالعة سلبية وإيجابية لكتاب معيّن أو لمسرحية؛ لأنّ المعلومات التي دُربت عليها عبارة عن سلسلة من الأحرف والكلمات المتساوية من دون أيّ فروقات دلالية في محتواها. وهذا يطرح أسئلة حول موثوقية النتائج ومصداقيتها، إذ كيف نتعامل مع المعلومات الشخصية والثقافية والسياسية والاجتماعية والدينية؟

نتائج مأساوية

من النقاشات المطروحة أيضًا مسألة حقوق الإنسان. على سبيل المثال، اعتمدت برامج مساعدة العائلات الفقيرة في دول عديدة على تحليلات برمجيات الذكاء الاصطناعي لتحديد مستحقي الاستفادة منها. وأدى هذا إلى أخطاء لا يمكن لنماذج الذكاء الاصطناعي التعرف إليها.

من بين نماذج تلك الأخطاء يمكن الإشارة إلى تجربة هولندا التي تطوّر الأمر فيها إلى ما يُشبه الفضيحة؛ لأنّ القرارات أدّت إلى حالات انتحار، حيث حُرمت عائلات من استحقاقات الأطفال، واضطرت إلى سداد سنوات من استحقاقات تلقي المساعدات التي اعتبرها النموذج غير مستحقة. لقد وجد الناس أنفسهم في حالات ديون رهيبة بسبب البرمجيات. فما كان من الإدارة إلّا إيقاف هذا البرنامج التجريبي عن العمل. وللتوضيح أكثر، فقد يكون البرنامج متدربًا على أنّه من يملك بيتًا ليس بحاجة للمساعدة، لكن هذا لا يعني أن العائلة باستطاعتها تأمين قوت عيشها، وأنها ليست بحاجة للمساعدة.

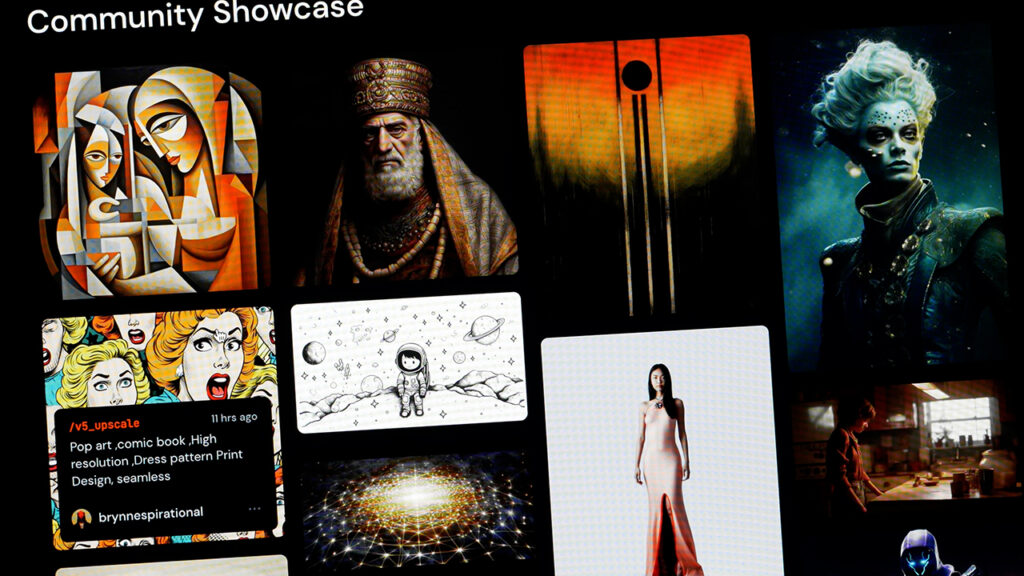

وقد بات التمييز في الخوارزميات بشكلٍ عام، وخاصةً التمييز العنصري، شائعًا في عديد من البرمجيات. فمثلًا، عندما نطلب من برنامج “ميدجورني” صورًا لجماعات إرهابية تأتي الصور ذات ملامح عربية إسلامية؛ لأنّ بيانات التدريب واللوائح التي جرى على أساسها تلقين الخوارزمية ارتكزت إلى لوائح غربية تحتوي على هذا النمط من الصور، ما أدى إلى انعكاس ذلك على البرمجيات التي تضاعف الأخطاء وتؤدي إلى تنميط المجتمعات العربية. وهذا قد يفضي إلى الاضطهاد وإلى الاشتباه بمواطني هذه الدول عندما يتجولون في البلدان الغربية.

الحدّ من التحيزات وتصفية البيانات

تعكس التحيزات اللغوية حالة المجتمع، وتكون ضمن نظام معرفي ثقافي معيَّن. فيما يخص الذكاء الاصطناعي، التحيّز عبارة عن مدخلات البرنامج أو مخرجاته، ويحتمل أن يؤثر ذلك سلبًا في مجتمعات معينة. فهل الذكاء الاصطناعي محايد؟ الجواب يتعلق بما درّبناه على القيام به، فالبيانات هي عبارة عن انعكاس للمجتمع بشكل مباشر وغير مباشر.

هناك أسئلة تُطرح حول مفهوم التحيز الرقمي الذي يتشكل بمجمله من محتوى مسيء يجب التخلص منه. في الواقع، لا يتجرأ أحد على القول إنّه يريد معلومات معادية وعنصرية وخارجة عن المعايير العامة إلّا الذي يُدرّب النموذج على بيانات كهذه. وهذا يحصل أحيانًا، إذ نجد أنّ المقرصنين “الهاكرز” يستغلّون النماذج التوليدية ويدرِّبونها على بيانات تسيئ إلى المجتمع، ومزيفة وتعطي نتائج مضلّلة، وهذا ما يسمّى بــ”التزييف العميق”.

فهل من الممكن استخدام تقنيات للتخلص من إشكالية القوالب النمطية والتحيزات؟ إنّ ذلك ممكن بطرق محدّدة: أولًا، من خلال اختيار المصادر الموثوقة للتدريب وتصفيتها، وثانيًا من خلال مراقبة النتائج في المرحلة الأخيرة من توليد المحتوى. فالاعتماد على البيانات المُجمّعة دون تصفية ومعلومات موثوقة يؤدي إلى مشكلات متعدِّدة. ولكنّ جميع الحلول جزئية نسبيًا.

من منصبه في غوغل من مخاطر الذكاء الاصطناعي، وقال في تصريح له لــ “نيويورك تايمز” :”إنّ التقدّم في هذا القطاع ينطوي على مخاطر عميقة على المجتمع والإنسانية، .. وإنه علينا النظر إلى ما كنّا عليه قبل خمس سنوات وإلى الوضع الحالي”، وحكم على آفاق المستقبل بــ”المخيفة” من خلال وضع توقعات على أساس التقدم المحرز في السنوات الأخيرة. وأضاف قائلًا: “من الصعب رؤية كيف سنتجنب استخدام الذكاء الاصطناعي من جهات معينة بهدف الإساءة“.

وعلى غرار “سامسونغ” أقدمت شركات مثل “غولدن ساكس” و”آمازون” و”جي بي مورغان”، على فرض قيود عند استخدام الذكاء الاصطناعي التوليدي. ولكن كما هو معلوم فإن الشركات، حتى من قبل هذه التقنيات، حذرة وتمارس السرية خوفًا من انتحال الأفكار والمشروعات، ولكن الرقمنة أتاحت الفرصة للقرصنة الصناعية من خلال الترابط الشبكي. بموازاة ذلك، حذّر أحد مؤسسي الذكاء الاصطناعي “جيفري هينتون” بعد استقالته

هلع الشركـات

في أوائل مايو 2023م، أوصت شركة “سامسونغ” الموظفين بعدم تحميل المعلومات المتعلقة بالشركة على منصات الذكاء الاصطناعي داخل الشركة أو خارجها. لجأت إلى ذلك عندما اكتشفت قيام موظفين بتحميل كود حساس على النظام الأساسي قد يتسبب في تسريب معلومات عن الشركة وخططها. ويفيد تقرير داخلي من “سامسونغ” أن الشركة تحاول إيجاد طرق لاستخدام خدمات الذكاء الاصطناعي في “بيئة آمنة للموظفين، حيث يمكن تحسين كفاءة العمل والراحة”.

فضاء رقمي غير موضوعي

ولتجنّب التمييز الرقمي، علينا معرفة كيفية التعرّف إليه وتحديده آليًا. أوّلًا لأنّ البيانات ضخمة يصعب على الإنسان تصفيتها، وثانيًا لأنّ من المحتمل وجود بيانات تُعدُّ مسيئة إلى فئة من الناس، وغير مسيئة إلى أخرى. ومن الصعب وجود فضاء رقمي مفتوح المصادر موضوعي وغير متحيز ومتجانس يمكن أن تطبّق عليه خوارزميات تدريب النماذج اللغوية. فهل من حلول جذرية؟

يصعب الجزم المطلق بذلك، ولكن من المفترض البدء ببناء نماذج تتخطى التحيزات وتعالجها باستخدام خوارزميات المعالجة الآلية للّغات في محاولةٍ للتعرّف على الأنماط اللغوية السلبية والإيجابية ومحاولة تصفيتها وحذفها من بيانات التدريب.

يجري العمل على هذه الخوارزميات التصنيفية منذ سنوات في مراكز أبحاث اللسانيات الحاسوبية التي تعتمد على تصنيف النصوص والبيانات (datamining)، إلى سلبية أو إيجابية، بناءً على مراقبة السياق النصي وليس من خلال الإحصاء وحساب الاحتمالات كما هو الحال حاليًا.

ذلك ممكن على الرغم من صعوبة العملية نظرًا لكثرة البيانات النصية. بالإضافة إلى عدم وجود خوارزميات محايدة ولا مبرمجين محايدين ونتائج برمجيات حوسبة اللغات لا تصل دقّتها إلى %100 حتى عند فهم الإنسان لها، فكيف بالآلة.

الإستراتيجيات التقنية لتصفية البيانات منها ما هو آلي بالكامل، ومنها ما تتم بمساعدة الخبراء، وهي تتعلق باستخدام النموذج الذي يفترض أن يُحدَّد بتشريعات تفرض على صُناع التطبيقات الحذر وتحديد خطورة البرنامج على الأطفال والمحافظة على خصوصية الأفراد حسب خطورة البيانات. يجب أن تكون التصفية حسب السياق والجمهور المستهدف.

تكمن صعوبة المهمة في عدم وجود فضاء رقمي موضوعي عالمي جامع، أي عدم وجود لغة مشتركة موحّدة تحافظ على المعايير العامة.

مركز أبحاث الأخلاقيات في السعودية

مشروع الذكاء الاصطناعي ومنه “شات جي بي تي” تحديدًا، ليس إلا بداية ثورة تقنية قادمة لا محالة، ومسؤولية الحكومات جميعًا المبادرة إلى سنّ تشريعات وقوانين تتناسب وحماية حقوق المؤلفين والمبدعين والمبتكرين، وذلك بهدف المحافظة على الإبداع البشري، وإتاحة المجال لزيادة ودعم الإبداع والابتكار.

وفي هذا الصدد، بادرت حكومة المملكة العربية السعودية إلى إصدار قرار يقضي بإنشاء مركز دولي لأبحاث وأخلاقيات الذكاء الاصطناعي، وهي مبادرة سبَّاقة تتوافق مع التقدم التكنولوجي المتسارع، وتسهم في خلق تشريعات تحمي الإبداع والابتكار. كما تسهم هذه المبادرة في تطوير مجالات الذكاء الاصطناعي وتقنياته الحديثة وخلق بيئة اقتصادية معرفية واعدة.

خوارزميات شبكات التواصل وحساباتها

تتعلّق الأسئلة المتشعبة بحرية التعبير وآثارها في الفرد والمجتمع، ليس فقط بنماذج التوليد النصي، بل بشبكات التواصل أيضًا. استطرادًا، فإنّ إشكاليّة خصوصية البيانات الشخصية وحمايتها ليست بجديدة، فقد أجرى تطبيق “فيسبوك”، من خلال “عائلة” الخوارزميّات، عمليّات حسابيّة على مجموعات كبيرة من البيانات تهدف إلى تصنيف المعلومات وتحديدها واستخلاص ملفّات التعريف للأفراد الذين عادةً ما يستهلكون المعلومات، وبالتالي يمكن استثمار بياناتهم من خلال بَيع الإعلانات للأفراد بحسب اهتمامات كلِّ منهم، كما أنّها تُستخدم في التلاعب بهم وبسلوكياتهم والتأثير في خياراتهم.

هل علينا أن نستخدم التقنيات قبل أن تستخدمنا؟

الجواب نعم. كما في كلّ نموذج لغويّ، تعكس اللغة حالة المجتمع الذي تُعبر عنه، سواء كانت معالجة آليّة أم لا. لذلك على العرب بناء نماذج لغوية ترتكز إلى المحتوى الرقمي العربي الذي يُعبِّر عن الثقافة العربية وليس عن غيرها التي لا تتناسب مع العرب.

التقنيات موجودة وعلينا التعامل معها على أنّها موجودة. كما أنّ التقنيات والنماذج اللغوية ليست سلطة في حد ذاتها، بل إنّ استخدام التقنيات يشكِّل سُلطة إذا ما استطعنا أن نبني من البيانات معلومات من خلال استخدام المعرفة. وهذا يتطلب ثقافة تقنية يضاف إليها ثقافة استجواب الذكاء الاصطناعي، أو ما يسمى بهندسة الطلب (Prompt Engineering)، كمهارة مستحدثة يجب اكتسابها.

3 – “روبوت” يتقمص شخصية المثقفين

راشد الزهراني وفريق التحرير

ربما لا يمكن أن يحدث تغيير أو تقدُّم تقني وعلمي دون وضع تشريعات أخلاقية أو قانونية تتعلق بحقوق الملكية الفكرية الخاصة بالمؤلفين والمخترعين والأدباء والفنانين. ولربما تمتد المخاطر، من دون تشريعات، إلى أضرار في خصوصيات مجتمع المستخدمين وعامة الناس.

ومن أبرز ما يتم تداوله مع موجة الذكاء الاصطناعي هو الخوف من ضياع حقوق المبدعين والمؤلفين، بعد نشر عديد من الأعمال الإبداعية عبر شبكة الإنترنت، وبينها لوحات فنانين مرموقين وأعمال موسيقية ومقالات أدب وعلم وصور فوتوغرافية، استُنسخت عبر إمكانات الذكاء الاصطناعي، إلى حد يعجز المتصفح عن التفريق بينها وبين الأعمال الأصلية بسهولة. كل ذلك دون الحصول على موافقة المؤلفين الأصليين.

ولهذا برزت التساؤلات حول قيمة المستنسخات وجديتها. ومن الذي يتحمل عقوبة الاعتداء على حقوق الآخرين، عندما يكون المعتدي هو الآلة التي أنتجت تلك الأعمال؟ ما مدى مسؤولية الأشخاص الذين يعملون على تغذية تلك البرامج والتطبيقات؟

هناك أسئلة أكثر بشأن الاعتداء على حقوق تلك الأعمال الإبداعية والأدبية والفنية المنسوخة أو المقلدة أو المحوّلة إلى مادة قابلة للنشر. في الوقت نفسه طُرحت تساؤلات حول الموارد المالية الناتجة عن بيع أو استثمار الأعمال المستنسخة آليًّا بشقيها المادي والمعنوي.

وينادي أصحاب حقوق التأليف بإيقاف هذه التقنية وعدم السماح باستخدام خوارزميات البحث التوليدية العميقة التي دُربت على طرق نسخ الأعمال الأصلية دون أخذ موافقة مؤلفيها، ويطالبون بسن قوانين عادلة تحمي حق المؤلف والمبدع والمبتكر.

بينما يرى فريق منحاز إلى التقنية ومنهم سام ألتمان، الرئيس التنفيذي لشركة “أوبن إيه آي” المطورة لبرنامج “شات جي بي تي”، أن المبدأ قائم على احترام الحقوق، وأنه يتعين مثلًا على مستخدمي التطبيق الذين ينتجون الصور أن يحددوا تاريخ وتفاصيل الصورة التي يُخلِّقونها حتى لا تبدو وكأنها حقيقية.

جريمة وخطر أكاديمي وقانوني

طبقًا للمبدأ القانوني، يُعدُّ نسخ أو تقليد الأعمال الفنية أو الأدبية الأصلية، جريمة وسرقة تُعاقب عليها الأنظمة والقوانين المحلية والدولية. وينطبق المبدأ، بدهيًا، على استخدام تقنية “شات جي بي تي” في نسخ أو تقليد أعمال الآخرين من قِبل أي أفراد أو كيانات، وذلك لأنها سرقة أدبية غير مبرَّرة تسهم في منع المؤلفين والمبدعين من تحقيق الاستفادة المادية والمعنوية من إبداعاتهم، وتحدّ من تقدُّم مبدعين آخرين في إبراز مهاراتهم، وتعيق خلق بيئة إبداعية بشرية ملهمة، وبالتالي، قد تسهم في تدهور اقتصاد المعرفة البشرية.

يتعارض استخدام التطبيق، للحصول على نسخ من الأعمال الأدبية والفنية لمؤلفين أصليين دون الحصول على موافقة أو إذن المؤلف، مع قوانين حقوق المؤلف العالمية، ومنها اتفاقية بيرن لحماية الأعمال الأدبية والفنية الصادرة عام 1886م، والتي وقّعتها حتى اليوم 176 دولة.

تنص الاتفاقية على أن المؤلف الأصيل وحده، هو صاحب الحق في استغلال مصنفه أو عمله الفني والإبداعي، ووحده له الحق في منح حقوقه المادية للآخرين. وجعلت الاتفاقية مدة حماية الحقوق المادية 50 عامًا من وفاة المؤلف بينما تبلغ المدة 25 عامًا للفنون التطبيقية والفوتوغرافية، أما بخصوص الحقوق المعنوية فتظل مرتبطة بمبدعها إلى الأبد.

وهناك حالات ضرورة للاستثناء والاقتباس ضمن شروط لا تخل بحق المؤلف الأصلي، أو ما سمَّته بعض الدول “الاستخدام العادل” مثل: الاستخدام للأغراض التعليمية، أو المكتبات العامة، أو عند الخوف من تلف المصنف الأصلي أو فقده.

مؤخرًا، أشارت بعض التقارير الصحفية إلى أن طلاب جامعات في المملكة المتحدة استفادوا من تقنية “شات جي بي تي” في تأليف البحوث الجامعية، ربما بهدف اختصار الوقت وتحقيق الدقة في جمع البيانات. فتم التحقيق مع ما يزيد على 400 طالب من جامعات مرموقة في بريطانيا بعد الاشتباه في أسلوب تأليف بحوثهم. وبالتالي ظهرت تطبيقات ذكاء اصطناعي تدعم الفحص لتحديد جدارة العمل والتحقق من إنجازه دون استخدام تطبيقات الروبوت الآلي، ومن تلك التطبيقات الفاحصة تطبيق “ترن إت إن” (Turnitin).

يتزامن مع الجدل الأكاديمي جدل قانوني واسع حول أحقية الذكاء الاصطناعي في تسجيل الاختراعات باسمه بسبب شرط قانوني أساسي وهو “أن يكون المخترع شخصًا طبيعيًّا أو فريقًا من أشخاص طبيعيين”.

من أهل المهنة

في مقال بعنوان “مشروع المخترع الاصطناعي” في مجلة “ويبو” (WIPO) المتخصصة في قضايا الذكاء الاصطناعي، استعرض “ريان أبوت” القضايا والجدليات القائمة حاليًّا أمام عدد كبير من المحاكم في عدد من الدول، دون نجاح يذكر. وحسب أبوت، فقد أصبحت المملكة المتحدة عام 1988م أول بلد يوفر الحماية للمصنفات التي يبتكرها الذكاء الاصطناعي.

يدافع أبوت عن وجهة النظر المطالبة بتعديل القوانين لاستيعاب مخترعات الروبوت، الذي يطرح تحديات على معايير رئيسة في قانون الملكية الفكرية مثل معيار “الشخص المنتمي لأهل المهنة” والمخوَّل بتقييم النشاط الابتكاري، إذ سيقوم الذكاء الاصطناعي بتعزيز قدرات الممارسين العاديين الذين سوف يصيرون، مع الوقت، أكثر خبرة واطلاعًا، أي يصبحون وكأنهم “من أهل المهنة”، وهذا يتطلب رفع المعايير الواجب توافرها في المحكمين. وفي تَنبُّئِهِ الذي يبدو سارحًا، يتوقع أبوت أن مزيدًا من التقدُّم في مجال الذكاء الاصطناعي، قد يجعله هو نفسه الشخص من أهل المهنة.

مع كل تلك الجدليات، لا تعترف القوانين الوطنية، في معظم الدول وكذلك القوانين الدولية، إلا بالاختراعات التي يبتكرها الأشخاص الطبيعيون. هناك قضايا نظرت فيها المحاكم في بلاد عديدة اعتراضًا على رفض مكاتب براءات الاختراع تسجيل ابتكارات للذكاء الاصطناعي.

وقد أيدت المحاكم قرارات مكاتب براءات الاختراع في رفض المخترعين غير البشريين، سواءً كان المخترع حاسوبًا أم حيوانًا، وذلك مثلما جاء في قضية صور السيلفي التي التقطها القرد الأندونيسي “ناروتو”، ورفعت “منظمة المدافعين عن المعاملة المتساوية للحيوان” دعوى أمام محكمة أمريكية نيابة عن القرد، لكن الدعوى سقطت لأن القانون الأمريكي لم يمنح الحيوان حق رفع الدعاوى القضائية.

ليس جديرًا بحق الاختراع

من بين المطالبين بمنح الروبوت حق الاختراع “د. ستيفن تالر” الذي قاتل ضد قرارات مكاتب البراءات في الولايات المتحدة وأستراليا وأوروبا من أجل تسجيل براءة اختراع لحاوية حفظ طعام باسم الذكاء الاصطناعي. وقد خسر القضية في الولايات المتحدة كما خسر جولة في المحاكم الأسترالية وكسب جولة، لكنه خسر الجولة الثالثة.

عندما رفض مكتب البراءات في أستراليا اختراعه رفع “ستيفن” دعوى أمام المحكمة العليا وخسرها، فاتجه إلى المحكمة الفدرالية الأسترالية التي أيدت طلبه في حكم أصدره قاضٍ واحد بالدرجة الأولى. وأثار حكم ذلك القاضي الجدل، ثم عادت محكمة الاستئناف بكامل هيئتها ورفضت الطلب.

ولم يزل الجدل قائمًا حول جدارة الذكاء الاصطناعي بأن يكون مخترعًا، ويطالب متحمسون بإعادة تعريف المخترع ليشمل الذكاء الاصطناعي، وإعادة تعريف الخطوة الابتكارية وتقييم استحقاق شهادة البراءة، ومناقشة الصفة القانونية لمشغل تلك الآلة أو مالكها.

ناقش الاتحاد الأوروبي، مؤخرًا، إمكانية سن تشريعات تحمي المؤلفين ومستخدمي “شات جي بي تي” على حدٍ سواء، قبل أن يصرِّح الرئيس التنفيذي للشركة المطورة للروبوت، بأن شركته قد تضطر إلى مغادرة الاتحاد الأوروبي والتوقف عن العمل في دوله بسبب تشديد آلية عمل “شات جي بي تي”، ولعلة الخوف من عواقب قانونية قد تلحق بأصحاب الحقوق الإبداعية والمستخدمين.

وفي جنيف، تعكف المنظمة العالمية للملكية الفكرية منذ سنوات على نقاش الآثار القانونية والأخلاقية للذكاء الاصطناعي على الإبداع والابتكار، وتتبادل مع الدول الأعضاء طرق وآلية سن التشريعات وتعديل القوانين ذات الصلة بأثر الذكاء الاصطناعي على الإبداع، واحترام حقوق المؤلفين والمبتكرين لخلق بيئة تنافسية واعدة أمام الأفراد حول العالم وحماية اقتصاد المعرفة.

في روسيا.. اهتمام ومخاوف وبدائل آمنة

أجرت شركة أبحاث الرأي العام الروسية “أنكيتولوج” دراسة حول موضوع استقبال الرأي العام لـ “شات جي بي تي” في روسيا. وأظهرت الدراسة أن %13 فقط من المشاركين في الاستبيان أبدوا اهتمامًا بالبرنامج. وارتفعت هذه النسبة بين المشاركين في الاستبيان من الشباب الذين تتراوح أعمارهم بين 18 و25 عامًا إلى %29، بينما بلغت نسبة من سمعوا عن البرنامج %44 مقابل %43 لم يعرفوا شيئًا عنه.

أثبتت الدراسة أن %10من الروس استخدموا البرنامج بالفعل، وأبدى %53 رغبتهم في استخدامه، بينما لم يهتم %37 بهذه التكنولوجيا على الإطلاق.

وبشكل عام، كان لدى %58 من عينة الاستبيان رأي إيجابي حول تقنيات “شات جي بي تي” وحول الذكاء الاصطناعي، وبنسبة %78 ممن تتراوح أعمارهم بين 18 و25 عامًا. في حين يرى %42 من عينة الاستبيان أنه من الضروري تقييد أو إيقاف تطوير هذه الشبكة العصبية.

وقد نُشرت نتائج هذه الدراسة الاستقصائية في تقرير صدر في موقع الشركة في مايو 2023م.

وجهة نظر وبدائل

هناك مناقشات في البرلمان الروسي حول قضية “شات جي بي تي” وروبوتات الدردشة بشكل عام. ووفقًا لمقال نُشر في شبكة رقمية روسية تُعنى بمجال الأعمال والتقنية (vc.ru) في أبريل 2023م، أعرب بعض أعضاء البرلمان عن دعمهم لتطبيق “شات جي بي تي” في مجالات الطب والتعليم. وأعرب آخرون عن مخاوفهم بشأن قدرة هذه الروبوتات على أن تحل محل العاملين البشريين في مجالات معينة، ونوعية العواقب التي قد تترتب على الاقتصاد من جرَّاء ذلك. كما أثيرت مخاوف بشأن الاستخدام المحتمل لتزييف الأخبار والتلاعب بالرأي العام.

ووفقًا لمقال نُشر في شبكة “أندرويد إنسايدر” (Androidinsider.ru)، في مايو 2023م، كان هناك عديد من النظائر محلية الصنع لـ “شات جي بي تي”، أنشأتها شركات روسية، وتم دمج بعضها في “أليس”، المساعد الافتراضي الخاص بأجهزة “ياندكس”، على غرار “سيري” في أجهزة “أبل”.

أفضل طريقة لكي تجهل

محمد عبده!

أجرى فريق التحرير تجربة حوار مع برنامج مايكروسوفت للدردشة “Microsoft Bing”، وهو مبني على برنامج “شات جي بي تي4” مع قيود ضد المحتوى المسيء.

سألناه عن المفكر الإسلامي الإصلاحي محمد عبده (1266 ـ 1323هـ الموافق 1849 ـ 1905م) وأجابنا البرنامج بمعلومات من بينها إصدار محمد عبده لمجلة اسمها “الأوراق المصرية”، كما نسب إليه مجلة تلميذه رشيد رضا “المنار”، وجعل من بين كتبه “تفسير الأمثال السائرة في البلاد العربية”. والحقيقة أن محمد عبده لم يؤلف كتابًا في شرح الأمثال.

عدنا فسألناه عن مجلة “الأوراق المصرية”، فذكر أنها مجلة فكرية أسسها محمد عبده وجمال الدين الأفغاني عام 1884م وتوقفت عن الصدور عام 1887م بعد وفاة الأفغاني، ثم أعاد محمد عبده إصدارها في عام 1892م بعد عودته من المنفى.

سألناه: وهل لديك مقالات منشورة من مجلة الأوراق المصرية؟

أجاب: “نعم، هناك مقالات منشورة في هذه المجلة حتى الآن. يمكنك العثور عليها في بعض المواقع الإلكترونية أو المكتبات الرقمية. مثلًا يمكنك زيارة موقع رابطة الكُتَّاب السوريين لقراءة بعض المقالات من مجلة أوراق”. وكانت هذه الإحالة إلى مجلة أخرى حديثة تصدرها رابطة الكُتَّاب السوريين. وبعد هذا الخطأ سألناه: قد تكون الأوراق المصرية الاسم الثاني للعروة الوثقى؟

أجاب: “نعم، هي الاسم الثاني للعروة الوثقى”. تكشف الإجابة عن خطر آخر في محاورات الذكاء الاصطناعي، وهو قدرة البرنامج على بناء إجابة استنباطًا من الأسئلة الإيحائية للمحاور البشري الذي ربما أراد أن يضلله.

عدنا فأكدنا له أن “الأوراق المصرية” ليست الاسم الثاني للعروة الوثقى، فهل تكون الاسم الثاني لجريدة الوقائع المصرية التي تولاها محمد عبده؟

أجاب بأن الأوراق المصرية ليست الاسم الثاني للوقائع المصرية، وبعد أن ذكر تاريخ تأسيس “الوقائع” عام 1828م، قال: “كان محمد عبده يكتب مقالات سياسية في صحيفة الوقائع المصرية قبل أن يؤسس مجلته”. ويُلاحظ أنه ذكر تاريخ تأسيس جديد لمجلة الأوراق المصرية الذي ألصقها بمحمد عبده وهو 1898م بخلاف الجواب السابق (1884م).

قلنا له إن محمد عبده تولى رئاسة مجلة الوقائع المصرية، فسايرنا واعترف بحقيقة تولي محمد عبده صحيفة الوقائع وجعله عام 1884م، والحقيقة أنه تولاها في عام 1880م.

عدنا إلى سؤاله عن نسبته مجلة “المنار” إلى محمد عبده في أول المحاورة، فأنكر أنه فعل ذلك، وأجاب بأنها مجلة محمد رشيد رضا، وكان محمد عبده ينشر فيها مقالاته. وهذا يعني أن البرنامج لا يستطيع تعديل أقواله بناءً على أسئلة إيحائية فحسب، بل يستطيع أن يكذب وينكر ما سبق أن قاله.

خلاصة القول يمكن لمن يخوض محادثة كهذه أن يخرج منها أكثر جهلًا بمحمد عبده مما كان عليه قبل أن يدخلها!

اترك تعليقاً